Plus que jamais, les derniers modèles d’IA brouillent les frontières entre les contenus créés par l’homme et ceux générés par l’IA.

Une gamme croissante de détecteurs d’IA prétend toutefois distinguer entre la rédaction humaine et artificielle.

Sont-ils vraiment fiables ? Comment cette détection de l’IA fonctionne-t-elle vraiment ?

Que vous souhaitiez protéger votre marque ou assurer une certaine discipline académique, voici un guide détaillé sur la précision et la fiabilité réelles des détecteurs d’IA.

Comment les détecteurs IA identifient les contenus générés par l’IA ?

Lorsque vous utilisez des détecteurs d’IA, vous tirez parti d’outils qui analysent le texte à l’aide de techniques avancées de machine learning et d’algorithmes.

Voici sur quels facteurs ces systèmes se basent pour donner leur jugement :

- Perplexité: Cette mesure évalue le degré de prévisibilité du texte. Les contenus générés par l’IA obtiennent souvent un faible score de perplexité car ils ont tendance à suivre des modèles prévisibles. Cela peut rendre le texte fluide, mais parfois trop uniforme ou fade.

- L’éclatement: Il s’agit de la variation de la longueur et de la structure des phrases. Votre texte peut mélanger des phrases courtes et nettes avec des phrases plus longues et plus complexes, montrant ainsi un degré élevé d’éclatement. Les textes générés par l’IA ne présentent généralement pas cette variété ; ils s’en tiennent à un modèle plus cohérent, que les détecteurs d’IA interprètent comme un signe d’auteur non humain.

- Analyse statistique : De nombreux détecteurs d’IA comparent votre texte à de vastes bases de données de textes connus générés par l’IA et écrits par des humains. Ils recherchent des modèles que l’on retrouve fréquemment dans les textes d’IA, comme certaines répétitions de phrases ou une syntaxe simplifiée.

- Techniques algorithmiques supplémentaires: Certains des détecteurs les plus sophistiqués analysent les nuances grammaticales, la cohérence des idées et même les éléments stylistiques. Ils évaluent si le texte ressemble à ce qu’un être humain écrirait ou s’il donne l’impression d’avoir été assemblé par un ordinateur.

Les détecteurs d’IA sont-ils vraiment fiables ?

Si vous comptez sur les détecteurs d’IA pour vérifier l’authenticité d’un contenu, vous devez évidemment vous assurer de leurs capacités et de leurs limites.

Voici ce que les recherches actuelles révèlent sur leur fiabilité :

- Moins de précision pour les contenus IA modifiés: Des études ont montré que les détecteurs d’IA ont du mal à maintenir une fiabilité élevée, en particulier lorsqu’ils rencontrent des contenus générés par l’IA délibérément modifiés pour éviter d’être détectés. Dans certains scénarios, les taux de précision ont chuté jusqu’à 17,4 %.

- Biais à l’égard des locuteurs non natifs: Les détecteurs d’IA nourrissent des biais à l’égard des contenus écrits par des locuteurs non francophones, les classant souvent à tort comme des contenus générés par l’IA. Cela peut conduire à des situations où un contenu authentique est signalé à tort.

- Faux positifs et faux négatifs : Le jugement des détecteurs d’IA est peu fiable, donnant assez souvent une réponse dite « incertaine ». Ils peuvent signaler certains contenus rédigés par des rédacteurs comme étant de l’IA et des contenus générés par l’IA comme étant des contenus humains, ce qu’on appelle respectivement des « faux positifs » et des « faux négatifs ». Un faux positif, -lorsqu’un contenu créé par l’homme est étiqueté à tort comme étant généré par l’IA – peut avoir des conséquences très importantes notamment dans les milieux universitaires.

- L’impact de l’évolution des modèles: les progrès continus des modèles LLM font que les détecteurs d’IA perdent de leur précision et de leur fiabilité au fil du temps. Par exemple, il y a toujours un énorme écart de précision dans la détection de GPT-3,5 par rapport à GPT-4 et Claude 3. Les détecteurs d’IA doivent constamment s’adapter pour rester pertinents.

Puis-je utiliser des détecteurs d’IA pour mon cas d’usage ?

Sur la base des conclusions tirées de ces études récentes, les détecteurs d’IA s’accompagnent de mises en garde qui requièrent votre attention.

Il faut d’abord reconnaître que les détecteurs d’IA ne sont pas infaillibles. Leur efficacité varie considérablement, et certains peuvent avoir des problèmes de précision lorsqu’ils sont confrontés à des contenus manipulés pour échapper à la détection. Ils ne devraient donc pas être les seuls arbitres dans des environnements à forts enjeux tels que les milieux universitaires ou l’édition professionnelle.

En outre, il ne faut pas négliger le risque de biais de ces outils. Comme on l’a vu, les détecteurs d’IA peuvent signaler à tort les contenus produits par des personnes dont le français n’est pas la langue maternelle. Ce biais complique encore les choses lorsque les enjeux concernent la crédibilité et la réputation d’une organisation.

Compte tenu de ces limites, l’approche la plus efficace consiste à utiliser les détecteurs d’IA comme un élément parmi d’autre dans votre process de vérification du contenu. Ces outils doivent compléter, et non remplacer, les jugements nuancés des réviseurs humains qui comprennent les subtilités du langage et du contexte que l’IA peut ne pas saisir pleinement.

Si vous décidez d’utiliser des détecteurs d’IA, il est essentiel de vous tenir au courant des dernières évolutions de la technologie de détection de l’IA. Des mises à jour régulières et un contrôle continu de leurs performances sont essentiels pour garantir que les détecteurs d’IA restent un élément utile de votre boîte à outils.

Vous devez également faire preuve de transparence quant aux outils que vous utilisez et à leurs limites lorsque vous portez un jugement à fort enjeu.

Les meilleurs détecteurs d’IA : Comparaison

Lorsqu’on choisit un modèle de détection IA, on veut un outil qui distingue non seulement par sa précision à détecter les contenus IA, mais aussi par un taux faible d’erreur de jugement (faux positif).

Des études récentes permettent de comparer la précision et fiabilité des outils disponibles sur le marché :

Études académiques

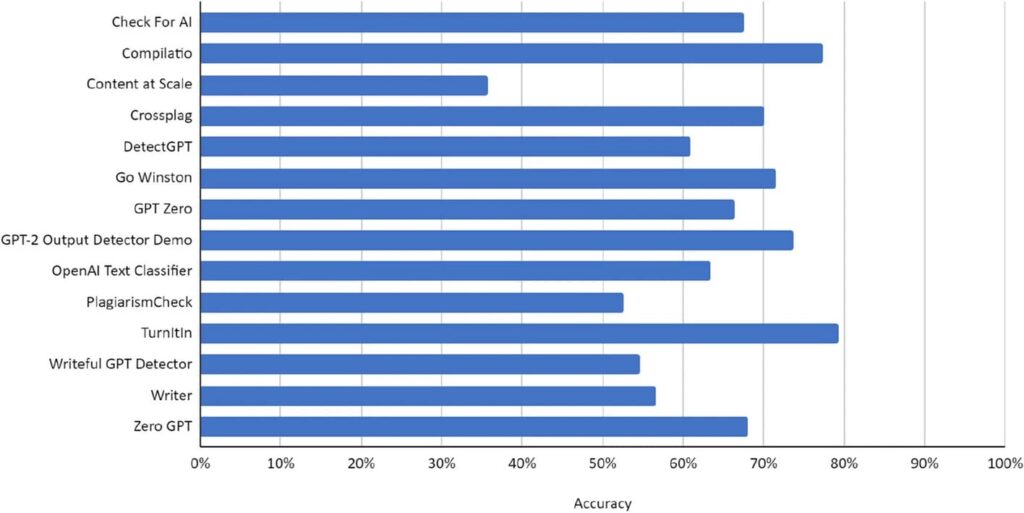

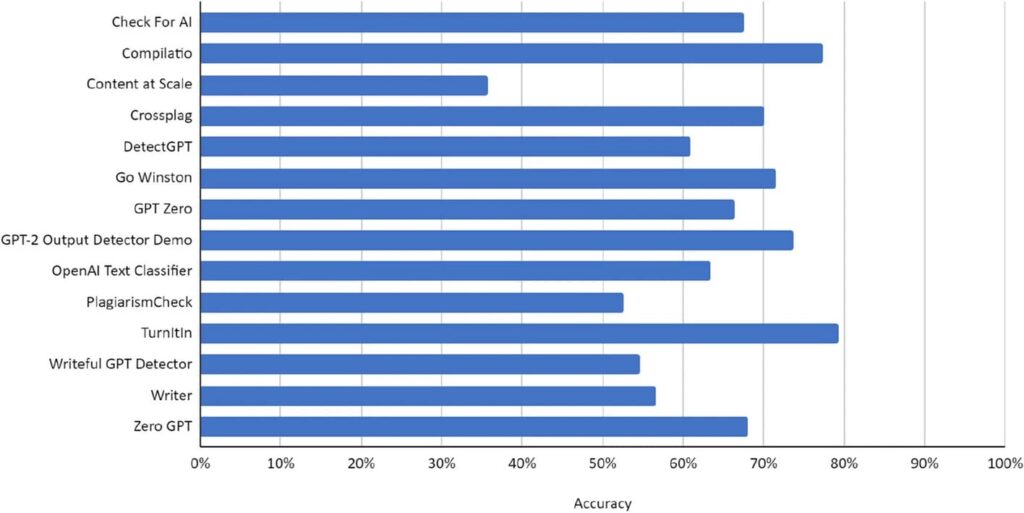

Une étude réalisée en décembre 2023 par l’International Journal for Educational Integrity a recueilli des données sur les détecteurs d’intelligence artificielle les plus répandus sur le marché.

Voici les résultats de ces modèles (attention cette étude ne contient pas les modèles les plus avancées mais est l’étude la plus fiable à ce jour):

- TurnItIn et OpenAI Text Classifier se distinguent par les taux de précision les plus élevés, ce qui indique qu’ils sont les plus susceptibles d’identifier correctement les contenus générés par l’IA et ceux générés par l’homme.

- Crossplag et Compilatio suivent de près, ce qui suggère qu’il s’agit d’options fiables, même si leur taux de précision est légèrement inférieur à celui des leaders.

- GPT Zero, Writer et Go Winston présentent des niveaux de précision modérés. Cela suggère que, bien qu’ils soient généralement fiables, il peut y avoir des lacunes occasionnelles dans l’identification correcte des types de contenu.

- Content at Scale et Check For AI se situent au bas de l’échelle de précision des outils présentés. Ils peuvent offrir des capacités de détection de base, mais pourraient potentiellement bénéficier d’une vérification supplémentaire par d’autres moyens.

Compte tenu de ces résultats, voici comment opérer votre choix :

- Contenu à fort enjeu : si votre stratégie de contenu implique des informations à fort enjeu pour lesquelles l’exactitude n’est pas négociable, comme les écrits académiques ou les rapports techniques, il pourrait être utile d’utiliser des outils tels que TurnItIn ou OpenAI Text Classifier.

- Contenu général : Pour un contenu plus général, où les inexactitudes occasionnelles sont moins critiques, un outil comme GPT Zero ou Writer peut offrir un bon équilibre entre performance et coût.

- Contraintes budgétaires : si votre budget est serré et que vous avez besoin d’une solution plus rentable, vous pouvez envisager Content at Scale ou Check For AI, tout en gardant à l’esprit qu’ils peuvent nécessiter une surveillance plus manuelle.

Étude privée

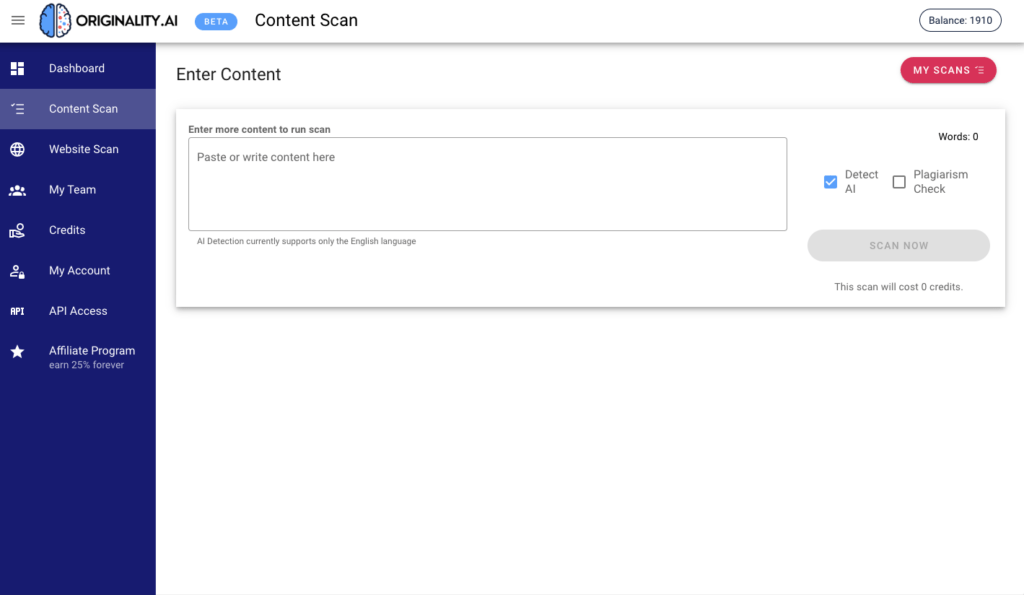

Originally.AI a également réalisé son propre benchmark en open-source pour comparer les modèles actuels de détection IA. Tout en tenant compte de la partialité évidente de l’entreprise, voici ce que dit la cartographie :

Originality.AI est clairement en tête du peloton avec un score F1 de 0,975. Cette mesure, qui combine la précision et le rappel, indique qu’il est bien équilibré entre l’identification des contenus générés par l’IA et le fait de ne pas signaler à tort des travaux rédigés par des humains. Sa précision est excellente (0,966), ce qui signifie que lorsqu’il identifie un contenu généré par l’IA, il a presque toujours raison. De plus, avec une spécificité de 0,965 et une précision exceptionnelle de 0,975, vous pouvez faire confiance à cet outil pour minimiser les faux positifs – seulement un taux de 0,035 – et limiter les fausses alertes à un murmure.

Plus loin, Winston.ai est un outil moins bon en termes de fiabilité. Malgré une précision décente de 0,886, son rappel et sa précision racontent une histoire différente, avec respectivement 0,368 et 0,660. Avec un taux de faux positifs de 0,046, il n’est pas le plus fiable pour différencier un texte humain.

Pareil pour Sapling.ai avec un score F1 de 0,379. La précision n’est pas si mal avec 0,765, mais un rappel de seulement 0,252 combiné à une précision plus faible de 0,588 suggère qu’il pourrait ne pas signaler tous les contenu IA, et un taux de faux positifs plus élevé de 0,076 signifie qu’il pourrait sonner quelques alarmes inutiles.

GPTZero affiche une précision impressionnante de 0,9585, ce qui suggère qu’il est digne de confiance lorsqu’il identifie un contenu généré par l’IA. Cependant, le faible rappel de 0,208, associé à une précision de seulement 0,599, implique qu’il pourrait manquer de nombreux contenus générés par l’IA. Sa spécificité est exceptionnelle (0,991), ce qui signifie que les faux positifs sont rares, mais est-ce suffisant ?

Pour Content at Scale, les chiffres montrent une spécificité équilibrée de 0,985 et une précision de 0,935. Cependant, un rappel de 0,204 et une précision de 0,594 indiquent qu’il n’est peut-être pas le meilleur pour identifier le contenu d’IA, même s’il se trompe rarement dans l’étiquetage du travail humain.

Enfin, Copyleaks est prometteur avec une précision de 0,975 – lorsqu’il détecte un contenu d’IA, vous pouvez presque compter sur lui. Avec le taux de faux positifs le plus bas (0,005), il se trompe rarement sur les contenus humains. Cependant, avec un rappel de seulement 0,198 et une précision de 0,596, il n’est pas le plus efficace pour détecter tous les textes écrits par l’IA.

En conclusion, Originality.AI semble être le meilleur candidat en termes de précision et de fiabilité, tandis que d’autres, comme GPTZero et Copyleaks, excellent en termes de précision mais peuvent nécessiter une vérification supplémentaire en raison d’un rappel plus faible.

Votre choix dépendra donc de votre tolérance en termes de taux d’erreur et de taux de précision.