Les détecteurs IA sont devenus des outils essentiels pour les éducateurs, les éditeurs et autres professionnels pour identifier des textes écrits par l’IA (comme ChatGPT).

Toutefois, de nombreuses recherches récentes ont soulevé de sérieuses inquiétudes quant à leur fiabilité- d’où l’importance cruciale de savoir quels sont les meilleur détecteur d’IA et leurs limitations respectives.

Dans ce guide, je vous montre donc les détecteurs IA français les plus fiables, en me basant sur leurs performances réelles sur mes tests mais aussi des études académiques objectives.

| # | Outil (lien) | Idéal pour | Points forts | Tarifs indicatifs* |

|---|---|---|---|---|

| 1 |

Originality.ai

Éditeurs & SEOPlagiat + IA

|

Vérification à volume pour équipes contenu / agences | Excellente détection, Détection robuste (paraphrases/humanizers), faible Faux positif avec seuils prudents | À l’usage ≈ $0.01 / 100 mots · Abonnement ≈ $14.95/mois (crédits inclus) |

| 2 |

Lucide AI

FR natifCrédits

|

Détection francophone (web, éducation, rédaction pro) | Bonne précision en Français, faux positif modéré | Pack Découverte ~9€ (100 crédits) · Essentiel ~27€ (385) · 670 ~47€ · 1 385 ~97€ · Abonnement ~29€/mois (500 crédits) |

| 3 |

GPTZero

ÉducationFaibles FP

|

Contrôle devoirs/rapports, mise en évidence des passages suspects | Très faible faux positifs, solide sur textes retravaillés, interface explicative | Web gratuit (limité) · Premium (GPTZeroX) ≈ 9.99€/mois · API à l’usage |

| 4 |

Winston AI

Rapports PDFExport

|

Organisations/éditeurs voulant des rapports détaillés et exports | Très bon sur IA “pure” et IA éditée, rapports téléchargeables | Essentiel ~$18/mois (≈80 000 mots) · Advanced ~$29/mois (≈200 000 mots) · Entreprise sur devis |

| 5 |

Copyleaks AI Detector

ÉcolesPlagiat+IA

|

Établissements & équipes qui veulent plagiat + IA dans un même flux | Bon sur IA brute & IA “humanisée IA”, prudent sur texte 100% humain | Ex. ~$9.99/mois (≈100 crédits ≈ 25 000 mots) · palier ~$13.99/mois (jusqu’à ≈300 000 mots) · Entreprise |

Méthodologie du classement

L’idée était évidemment pas de recopier des comparatifs trouvés sur Google, mais de tester les détecteurs dans des situations proches de leur performance réelle.

Pour comparer les outils, j’ai donc d’abord utilisé mon propre sample de texte français :

Voici les 5 cas :

- Texte 100 % IA (GPT-5 brut)

- Article court entièrement généré par GPT-5, sans aucune modification.

- C’est le cas “facile” : si un détecteur se trompe déjà là, on peut le sortir du classement.

- Texte IA réécrit par un humain (cas subtil)

- Même texte que le n°1, mais réorganisé et reformulé par un humain (changement de structure, reformulation, ajout de transitions, etc.). On garde une partie des “patterns IA” mais on injecte du vrai style humain.

- C’est le texte le plus important du test : c’est là que les bons détecteurs se séparent des autres.

- Texte IA “humanisé” par un autre outil IA

- Texte n°1 passé dans un humanizer IA (un outil qui prétend rendre le texte “indétectable”). L’outil reformule, change le vocabulaire, réarrange les phrases pour tromper les détecteurs.

- Objectif : vérifier quels détecteurs tombent dans le panneau.

- Texte 100 % humain

- Texte rédigé de zéro, sur le même sujet, en suivant le même fil d’idées, mais avec une formulation vraiment personnelle.

- Ce texte sert à mesurer un point critique : est-ce que le détecteur risque d’accuser à tort un texte humain d’être écrit par une IA ?

- Texte GPT-5 avec recherche et raisonnement avancé

- Texte généré par GPT-5 en mode “recherche + raisonnement” (citations, chiffres, faits, structure plus poussée). Ce type de contenu ressemble beaucoup à ce que vous pourriez produire pour un rapport ou un article long.

- Intérêt : voir si les détecteurs sont encore capables de l’identifier comme IA ou s’ils se laissent tromper par le côté très informatif.

Mais je ne me suis pas arrêté là. J’ai aussi croisé mes observations avec le benchmark académique RAID – un très grand ensemble de données pour l’évaluation robuste des détecteurs de texte générés par des machines – Il teste les détecteurs d’IA sur plus de 6 millions de contenus générés par l’IA.

Attention cependant ce benchmark se base sur un corpus anglophone, de sorte que je ne pouvais pas simplement me baser sur ces conclusions (en plus du fait que tous les outils ne sont pas présents dans cette étude).

🇫🇷 Découvrez Lucide IA — le seul détecteur 100 % français, entraîné sur des textes français

Lucide IA est le détecteur de texte IA conçu pour comprendre la richesse du français. Développé et entraîné exclusivement sur des textes francophones, il offre une analyse linguistique fine et fiable.

Idéal pour les enseignants, éditeurs, journalistes et professionnels souhaitant vérifier l’authenticité de leurs contenus. Testé & recommandé par l’équipe!

🔍 Essayez Lucide IA gratuitement

1. Originality.ai

Originality.ai est un détecteur d’IA et un vérificateur de plagiat destiné aux éditeurs de contenu et aux rédacteurs professionnels. Il est commercialisé pour une utilisation « sérieuse » par les équipes et les agences qui créent de gros volumes de contenu.

Comment il fonctionne ?

Originality AI utilise un modèle d’apprentissage automatique pour évaluer la probabilité qu’un texte soit généré par l’IA. Il analyse la structure et la perplexité et renvoie en fonction un score de probabilité IA.

(L’entreprise n’a pas divulgué son algorithme exact, mais il s’agit vraisemblablement d’un modèle transformeur finement ajusté, entraîné sur de vastes ensembles de données de textes humains et d’IA).

Essayez Originality.AI Gratuitement Ici

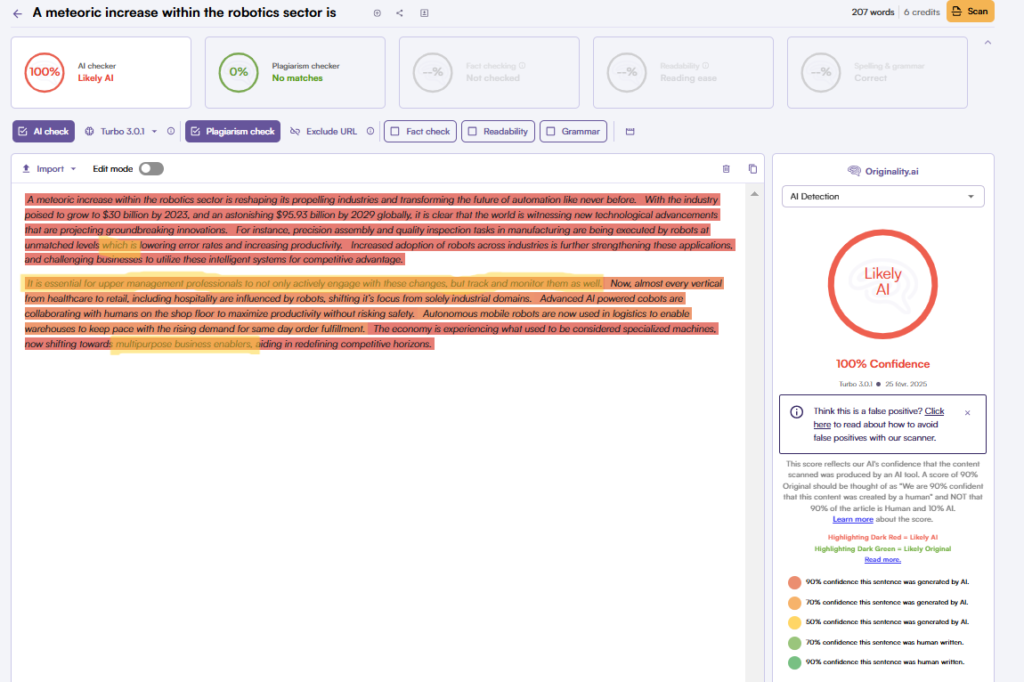

Performance sur mon test

Sur mes 5 textes “robots collaboratifs”, Originality est celui qui a été le plus aligné avec la réalité :

Texte 1 – 100 % IA (GPT-5 brut)

- Résultat : ~100 % IA, 0 % humain.

- Rien à dire : il identifie l’IA sans hésitation.

Texte 2 – IA réécrite par un humain (cas subtil)

- C’est là que beaucoup d’outils se plantent… et que l’on voit la différence.

- Originality classe le texte comme quasi entièrement IA, avec parfois une petite marge “humaine”, mais globalement : “Ce texte reste majoritairement généré par une IA.”

- C’est exactement ce que vous voulez entendre sur un texte qui, dans le fond, est encore très IA, même si vous avez retouché la forme.

Texte 3 – IA “humanisée” par une IA

- Ici encore, Originality ne se laisse pas berner.

- Les tests (et les études RAID) montrent qu’il est très robuste aux paraphrases et aux humanizers : il garde un très haut niveau de détection, là où d’autres s’effondrent.

Texte 4 – texte 100 % humain

- Votre texte entièrement rédigé à la main est classé 100 % humain dans tes essais, et les études indiquent un taux de faux positifs autour de 0,5 %, ce qui est très bas.

- En pratique : 1 texte humain sur 200 risque d’être injustement marqué comme IA — ce qui reste rare, mais pas impossible.

Texte 5 – GPT-5 avec recherche & raisonnement avancé

- Originality le voit comme 100 % IA.

- Le fait que le texte soit très factuel, rempli de références et bien structuré n’empêche pas la détection : c’est un bon signal pour vous, qui travaillez souvent avec des contenus “experts”.

Performance académique

- Taux de précision le plus élevé : dans le benchmark RAID, Originality.ai a été le détecteur le plus précis dans l’ensemble. Il a atteint une précision d’environ 85 % sur l’ensemble de données de test de base (avec un taux de faux positifs de 5 %). En d’autres termes, il a détecté le plus grand nombre de textes écrits par l’IA tout en maintenant un faible taux de fausses alertes.

- Faux positifs élevés : Originality.ai a un faible taux de faux positifs lorsque l’on choisit un seuil de faux positifs raisonnablement bas pour les éviter. Ce n’est cependant pas le plus bas du marché. Avec un seuil de faux positifs élevé, il y a de nombreux cas où Originality.ai signale des contenus légitimes revendiqués par des utilisateurs en ligne.

- Bonne Robustesse : Cet outil s’est révélé remarquablement robuste face à de nombreuses tactiques adversariales courantes. Selon l’étude RAID, Originality.ai s’est classé premier dans 9 des 11 tests adversarials (et deuxième dans un autre). Il gère particulièrement bien les contenus d’IA paraphrasés – détectant le texte généré par paraphrase avec une précision de 96,7 % contre une moyenne d’environ 59 % pour les autres détecteurs. En bref, les stratégies telles que l’utilisation d’un thésaurus ou la reformulation avec des outils (par exemple QuillBot) sont peu susceptibles de tromper Originality.ai. Malgré une grande robustesse générale, Originality.ai a des angles morts avec quelques « techniques de contournement rarement utilisées ». Il a notamment eu des difficultés avec l’attaque par homogyphe (remplacement des caractères par des sosies) et l’ajout d’espace (Unicode invisible inséré dans le texte).

- Manque de transparence : alors qu’Originality.ai se targue d’utiliser une grande « puissance de calcul » et des techniques avancées de NLP, il s’agit en quelque sorte d’une boîte noire – ils n’expliquent pas l’algorithme en détail, et il s’agit d’un logiciel propriétaire, ce qui fait que l’on doit se fier à ce qu’ils disent.

Prix et accès :

Originality.ai fonctionne selon un modèle de tarification basé sur le crédit. Il propose des plans de paiement à l’utilisation autour de 0,01 $ par 100 mots numérisés (environ 0,05 $ pour un article de 500 mots). Il existe également un abonnement mensuel (~14,95 $/mois) qui comprend une allocation globale de crédits. Il n’y a pas de version gratuite permanente, mais les nouveaux utilisateurs reçoivent parfois quelques crédits pour l’essayer.

Les meilleurs cas d’utilisation :

Originality.ai convient parfaitement aux spécialistes du marketing de contenu, aux blogueurs et aux rédacteurs qui doivent régulièrement s’assurer que leurs rédacteurs n’utilisent pas d’outils d’IA (ou vérifier l’originalité à des fins de référencement).

Pour un usage académique ou éducatif, Originality.ai est moins courant (les éducateurs utilisent souvent Turnitin ou des outils gratuits à la place, car Originality est payant et a été conçu davantage pour le contenu web). Comme bonne pratique, certaines équipes de contenu utilisent Originality.ai comme premier passage et peuvent ensuite revérifier les textes suspects avec un second détecteur (comme GPTZero) pour confirmation, en particulier pour les textes qu’Originality marque comme « humains » en dépit des doutes.

2. Lucide AI

Contrairement à la plupart des outils américains optimisés pour l’anglais, Lucide est entraînée sur des textes francophones. Ce qui le rend vraiment intéressant à utiliser.

Essayez Lucide AI Gratuitement Ici

Performances

D’abord, il faut être transparent :

- il n’existe pas (à ce jour) d’étude académique indépendante du type RAID ou autre benchmark public dédié à Lucide AI ;

- on doit donc se baser sur ses propres tests utilisateurs.

Selon mon propre comparatif francophone placent Lucide AI, j’ai constaté ceci :

- Lucide a reconnu un texte 100 % généré par GPT-5 comme 0 % humain ⇒ excellent signal ;

- le même texte, légèrement réécrit par un humain, il l’a identifié comme 32 % humain : on voit que l’outil capte une “couche” humaine, mais considère encore le texte comme fortement IA, ce qui est plutôt cohérent ;

- Un texte rédigé entièrement à la main → 100 % humain, comme attendu.

Cela semble montrer globalement que Lucide IA fait bien la différence entre :

- du 100 % IA,

- du 100 % humain,

- et du “mix” humain + IA.

En vue de tous mes tests, Lucide AI est fiable pour détecter des textes IA français de manière équivalentes aux outils leaders anglophones.

Quel est le prix de Lucide AI ?

Lucide AI fonctionne principalement sur un modèle à crédits (vous achetez des “crédits” correspondant à une quantité de mots ou d’analyses) plutôt que sur un tarif forfaitaire unique illimité.

- Le « Pack Découverte » : 100 crédits pour ~9 €. Chaque crédit permet l’analyse d’environ 1 000 mots.

- Le « Pack Essentiel » : 385 crédits pour ~27 € (~0,07 € par crédit) indiquant un palier plus économique par grande quantité.

- Offres plus importantes : par exemple 670 crédits pour ~47 €, ou des packs allant jusqu’à 1 385 crédits (~97 €) ou 5 570 crédits (~390 €) pour usage entreprise.

- Option abonnement mensuel : il existe des formules mensuelles “Abo+” à ~29 €/mois pour 500 crédits par mois.

Quelques constats intéressants :

- Sur le marché francophone, les tarifs de Lucide AI sont inférieurs ou comparables aux concurrents internationaux. Exemple : certains détecteurs américains facturent ~1,50 € pour 1 000 mots analysés. Ici, chez Lucide, on est plutôt entre ~0,70 à ~0,90 € pour 1 000 mots.

- Le modèle à crédit vous permet d’éviter un abonnement fixe si vous avez un usage ponctuel — c’est un point fort.

- A noter : l’absence dommageable d’essai gratuit complet.

3. GPTZero

GPTZero est l’un des premiers détecteurs de contenu d’IA et l’un des plus utilisés. ll est clairement l’un des détecteurs les plus avancés du lot en termes algorithmiques. Il a également l’interface la plus détaillée.

Essayez GPTZERO.AI Gratuitement Ici

Comment il fonctionne ?

GPTZero utilise deux mesures principales dans son analyse : la perplexité (degré de prévisibilité du texte) et l’éclatement (variation de la longueur des phrases).

En les comparant à des modèles d’écriture typiquement humains, il évalue la probabilité qu’un texte ait été écrit par l’IA.

Performance sur mes propres tests

Texte 1 – 100 % IA (GPT-5 brut)

- Il détecte le texte comme quasiment 100 % IA, sans ambiguïté.

Texte 2 – IA réécrite par un humain (cas subtil)

- C’est là que GPTZero montre vraiment sa valeur. Sur ce texte retravaillé à la main, il le classe à 98 % IA, avec environ 2 % humain.

Texte 3 – IA “humanisée” par une IA

- Il continue de détecter une forte probabilité IA, malgré le passage dans un “humanizer”.

- Il est donc plus robuste que des outils comme CopyLeaks ou Winston sur ce type de manipulation.

Texte 4 – texte 100 % humain

- Sur mon texte rédigé entièrement à la main, il donne ≈ 98 % humain. Il reste donc très prudent avant de classer un texte humain comme IA, même j’ai parfois repris certaines tournures de l’IA.

Texte 5 – GPT-5 avec recherche & raisonnement avancé

- Il le marque comme 100 % IA.

Performance académique :

- Bonne précision avec les modèles les plus récents : GPTZero arrive à battre Originality AI sur les modèles les plus récents, mais a une précision inférieure en générale, soit 66,5 % pour l’ensemble des modèles, ce qui signifie qu’il passe à côté d’environ 35 % des textes IA.

- Taux de faux positifs très faible : L’étude du RAID montre que GPTZero a l’un des taux de faux positifs les plus bas (~0%), battant Originality AI ()~1%.

- Le plus robuste face aux attaques adversariales : dans le test de référence RAID, la précision de GPTZero n’a que légèrement diminué lorsque le texte de l’IA était paraphrasé, comportait des fautes d’orthographe ou même lorsque des caractères homoglyphes étaient introduits – dans certains cas, les performances sont restées pratiquement inchangées.

- Difficultés avec les textes courts : Si vous saisissez des textes très courts ou seulement quelques phrases, GPTZero n’est souvent pas en mesure d’émettre un jugement fiable. Il a été principalement conçu pour des textes de la longueur d’un paragraphe à celle d’une dissertation.

Prix et utilisation

GPTZero propose une version web gratuite généreuse qui permet un nombre limité de vérifications par jour. Il existe également une inscription gratuite qui permet d’augmenter les limites.

Pour les utilisateurs intensifs, GPTZero propose un plan premium (GPTZeroX) destiné aux éducateurs et aux organisations, qui démarre à environ 9,99 euros/mois pour une utilisation et des fonctionnalités étendues.

L’API est également disponible pour les développeurs sur la base d’un paiement à l’utilisation, ce qui est utile si vous souhaitez intégrer GPTZero dans une application ou un flux de travail. Dans l’ensemble, le coût est faible par rapport à d’autres détecteurs – de nombreux utilisateurs se contentent de la version gratuite, et même la version premium est abordable pour les écoles.

Les meilleurs cas d’utilisation :

GPTZero est un excellent détecteur polyvalent, particulièrement adapté au monde universitaire et à l’éducation. Les enseignants et les professeurs peuvent utiliser la version gratuite pour vérifier si les travaux des étudiants contiennent de l’IA, sachant que si GPTZero signale un élément comme étant généré par l’IA, il est probablement correct (une étude a noté que « si GPTZero dit IA, il est très probable qu’il s’agisse d’IA », étant donné le faible taux de faux positifs). Sa décomposition détaillée et la mise en évidence des phrases suspectes facilitent la collecte de preuves.

Les étudiants ou les auteurs peuvent également utiliser GPTZero pour vérifier eux-mêmes leur travail – par exemple, pour voir si leur texte a l’air d’avoir été généré par l’IA, et ensuite réviser ces parties.

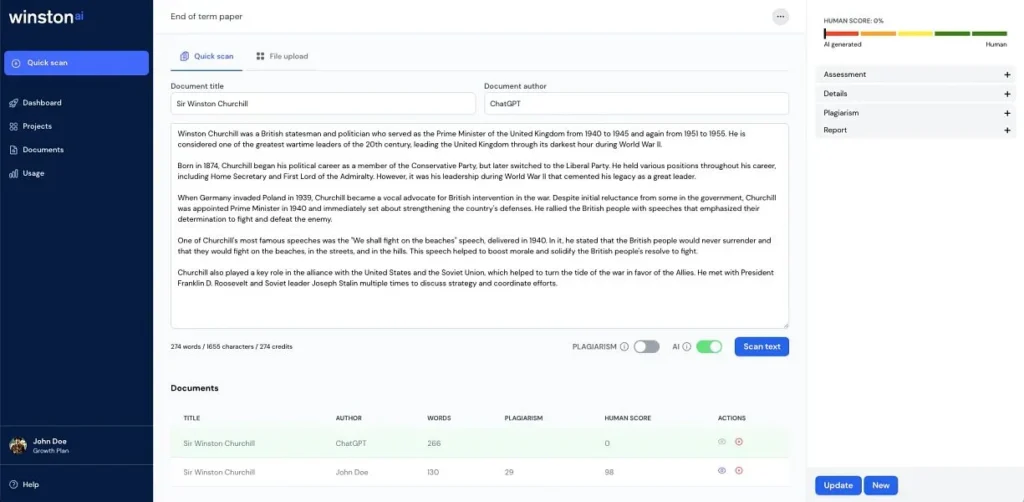

4. Winston AI

Winston AI est un détecteur américain plus récent qui offre également de la détection IA.

Comment il fonctionne ?

Il utilise un modèle d’IA propriétaire pour évaluer le texte, probablement en employant un classificateur basé sur un grand transformeur.

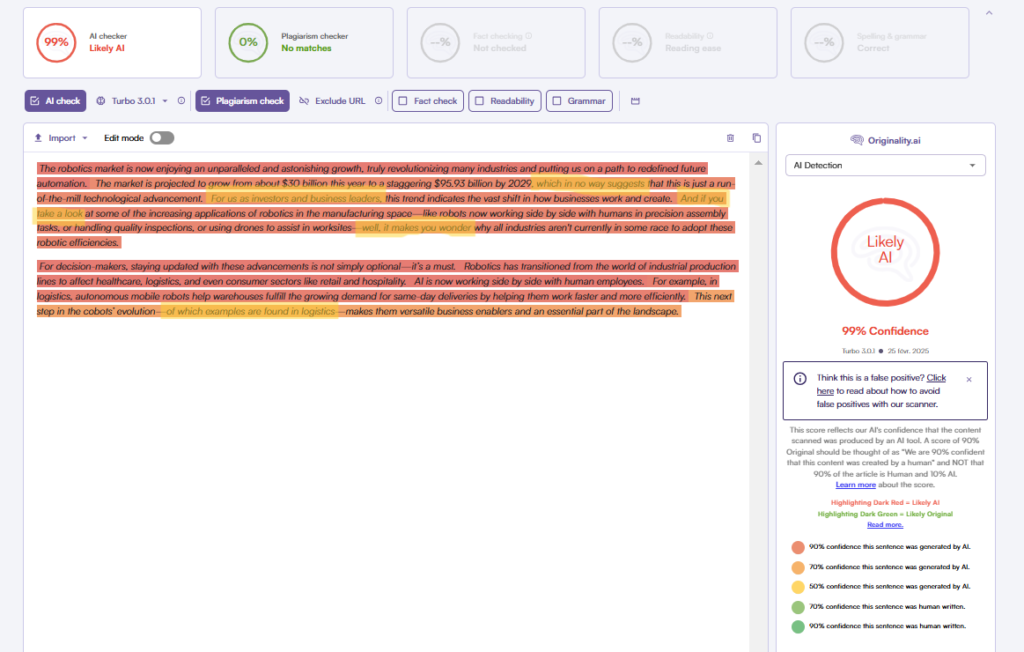

Performance sur mon test

Winston AI se comporte globalement bien… jusqu’au moment où ça devient subtil.

- Texte 1 – 100 % IA (GPT-5 brut)

- Winston détecte correctement l’IA : score humain proche de 0 %.

- Rien à redire : sur l’IA pure, il fait le job.

- Texte 2 – IA réécrite par un humain

- C’est là que le bât blesse. Là où d’autres détecteurs (Originality, GPTZero) voient encore massivement de l’IA, Winston se laisse plus facilement convaincre. Mon texte, pourtant encore très “IA dans le fond”, est considéré comme ≈ 88 % humain

- Texte 3 – IA “humanisée” par une IA

- Sur ce cas, il reste performant : il continue à voir beaucoup d’IA malgré le “humanizer”.

- Texte 4 – texte 100 % humain

- Il classe bien le texte comme humain, ce qui est rassurant.

- Texte 5 – GPT-5 avec recherche & raisonnement avancé

- Winston le marque bien comme IA, même si on note une légère hésitation (un peu plus de “human” que sur le texte 1).

Globalement, on peut dire que Winston est très bon sur l’IA brute, mais qu’il a plus de mal dès qu’un humain vient mélanger sa patte.

Performances académiques

- Très grande précision, en particulier sur les textes ChatGPT : Winston AI détecte très bien les textes générés par des modèles bien connus tels que GPT-3.5 (ChatGPT) et GPT-4 avec une précision quasi parfaite. Dans le benchmark RAID, Winston a atteint environ 90%. Mais dans l’ensemble, il ne bat pas Originality AI 71% parce qu’il est moins précis avec les anciens et les nouveaux modèles.

- Taux de faux positifs plus élevé que les autres modèles : Winston obtient un taux de faux positifs supérieur à celui de GPTZero, Originality AI et Binoculars, qui est d’environ 1 % avec un seuil de taux de faux positifs bas, ce qui peut encore être acceptable et peut être réduit avec un seuil de taux de faux positifs encore plus bas.

- Vulnérable aux modifications adversariales, mais capable de détecter des contenus d’IA lourdement édités. Dans l’évaluation RAID, Winston a détecté avec précision des textes générés par l’IA, même lorsque ces textes avaient été considérablement modifiés par l’homme, mais il est vulnérable aux attaques par homoglophyne et aux ajouts d’espace.

Prix et accès :

Winston AI est disponible sous forme d’abonnement. Le plan de base (essentiel) coûte environ 18 $ par mois (ou 144 $/an) et permet de numériser jusqu’à 80 000 mots par mois. Le niveau suivant, Advanced, est d’environ 29 $/mois et permet de scanner jusqu’à 200 000 mots. Winston propose également un plan d’entreprise personnalisé pour les volumes plus importants. Il est à noter que Winston facture des « crédits » par mot (1 mot = 1 crédit pour la détection de l’IA), ce qui signifie que vous payez pour une quantité de mots. La plateforme propose un essai gratuit (par exemple, 2 000 mots pendant 7 jours lors de la dernière vérification) afin que les utilisateurs puissent la tester.

Les meilleurs cas d’utilisation :

Les institutions professionnelles et universitaires qui ont besoin d’une vérification approfondie du contenu bénéficieront le plus de Winston AI. Par exemple, les éditeurs, les rédacteurs en chef de revues et les agences de contenu pourraient utiliser Winston pour vérifier en une seule fois le contenu AI et le plagiat dans les soumissions – les rapports détaillés (y compris l’exportation des résultats au format PDF) facilitent l’archivage des preuves.

5. Copyleaks AI Detector

Copyleaks AI Content Detector est une solution de détection deIA développée par une entreprise principalement connue pour ses logiciels de détection du plagiat. Copyleaks a été l’une des premières entreprises à proposer un détecteur de texte IA au début de l’année 2023, et il a été adopté dans certains établisssement éducatifs.

Comment il fonctionne ?

Le détecteur d’IA de Copyleaks utilise une combinaison de modèles d’IA pour analyser les textes. D’après sa documentation, il utilise probablement des classificateurs basés sur des transformeurs et des analyses statistiques (par exemple, la perplexité) pour attribuer un score de « probabilité générée par l’IA ». Copyleaks met en évidence les parties de texte qui semblent avoir été écrites par une IA.

Performance sur mon propre test

Comme Lucide AI, Copyleaks n’est pas présent dans les benchmarks académiques comme RAID. En-dehors des études avec peu d’échantillons, on est donc obligé de se baser sur ses propres recherches.

Voici comment l’outil s’est comporté dans mon protocole de test :

- Texte 1 – 100 % IA (GPT-5 brut)

- Là, rien à dire : CopyLeaks fait le job. Le texte est reconnu comme massivement généré par IA.

- Texte 2 – IA réécrite par un humain (cas subtil)

- C’est là que les choses se gâtent. Alors que le texte garde encore pas mal de “patterns IA” (structure, enchaînements, façon de développer les idées), CopyLeaks ne voit plus rien : il le classe comme 0 % IA.

- Texte 3 – IA “humanisée” par une autre IA

- Ici, CopyLeaks s’en sort correctement : il détecte toujours l’IA. Ça montre qu’il est relativement robuste face à certains “humanizers IA”, mais pas face à un humain qui retravaille vraiment le texte.

- Texte 4 – texte 100 % humain

- Bon point : le texte entièrement rédigé à la main est bien reconnu comme 0 % IA. Donc, côté faux positifs, CopyLeaks reste prudent : il ne va pas accuser un humain trop facilement.

- Texte 5 – GPT-5 avec recherche & raisonnement avancé

- Là encore, il marque correctement le texte comme IA. Même si le contenu est riche en faits, structuré, assez “expert”, l’outil ne se laisse pas duper.

Prix et accès :

Copyleaks propose des formules d’abonnement pour son détecteur d’IA. Par exemple, un plan est d’environ 9,99 $ par mois pour 100 crédits (avec 1 crédit ≈ 250 mots) et des niveaux plus élevés comme ~13,99 $/mois pour 1 200 crédits. En termes pratiques, 9,99 $ couvrent environ 25 000 mots et 13,99 $ couvrent jusqu’à 300 000 mots, ce qui est suffisant pour la plupart des utilisateurs individuels ou des enseignants. Il existe également une tarification d’entreprise pour les institutions.

Les meilleurs cas d’utilisation :

Les établissements d’enseignement et les entreprises qui ont besoin d’une solution de bénéficieront de Copyleaks. Par exemple, une université qui n’a pas souscrit à Turnitin peut utiliser Copyleaks comme alternative pour analyser les travaux des étudiants à la fois pour le plagiat et les sections générées par l’IA. Copyleaks peut être intégré dans les portails de soumission de travaux, ce qui le rend transparent pour les enseignants.intégrée détection du plagiat et de l’IA

Pour les enseignants ou les professeurs, Copyleaks propose un outil web plus manuel (télécharger un document sur leur site pour obtenir un score de contenu AI), qui peut être utilisé au cas par cas si tu t’inscris pour un compte. Les éditeurs et les rédacteurs en chef peuvent également utiliser Copyleaks s’ils souhaitent un deuxième niveau de contrôle après la vérification du plagiat.

Pour les développeurs, l’API de Copyleaks est une option, bien qu’elle soit peut-être plus chère que d’autres.

Mentions honorables

Voilà donc tous les détecteurs d’IA les plus précis du marché. Mais il en existe bien d’autres, dont certains méritent des mentions honorables.

ZeroGPT est l’un des outils de détection d’IA « OG » qui est devenu populaire en raison de son interface simple et de son accès gratuit. De nombreux utilisateurs occasionnels ont essayé ZeroGPT parce qu’il ne nécessite pas d’enregistrement et qu’il permet des entrées de texte assez importantes (jusqu’à ~15 000 caractères par chèque dans la version gratuite). Il propose également une API payante et une version Pro pour des limites plus élevées. ZeroGPT a une faible précision et un taux de positivité élevé, mais c’est peut-être l’un des meilleurs outils d’IA gratuits que vous pouvez trouver en ligne.

Il existe plusieurs autres détecteurs d’IA comme le détecteur Sapling AI, Crossplag, le détecteur Content at Scale, le détecteur Writer.com, etc. Certains d’entre eux ont des atouts spécifiques. Cependant, aucun d’entre eux n’a surpassé les détecteurs ci-dessus dans l’ensemble.

Limites et défis des détecteurs d’IA

Bien que les détecteurs d’intelligence artificielle aient progressé rapidement, il est essentiel de comprendre leurs limites et les défis qui subsistent. Aucun détecteur n’est infaillible, et les utiliser à l’aveuglette peut conduire à des erreurs. Voici quelques-uns des principaux problèmes posés par les méthodes actuelles de détection de l’IA :

- Faux positifs (erreur d’étiquetage d’un texte humain comme étant de l’IA) – Il s’agit du problème le plus connu. Les détecteurs identifient parfois des textes parfaitement écrits par des humains comme étant générés par des machines. Les auteurs dont l’anglais n’est pas la langue maternelle sont particulièrement exposés : une étude a montré que plus de 60 % des essais rédigés par des étudiants en anglais langue seconde étaient faussement étiquetés comme étant de l’IA par les détecteurs, probablement parce que le vocabulaire et la grammaire les plus simples peuvent ressembler à la production de l’IA. Même des outils sophistiqués ont donné des résultats faussement positifs pour certains textes – par exemple, les résumés scientifiques ou les formules toutes faites peuvent dérouter les détecteurs. Un faux positif peut avoir de graves conséquences, qu’il s’agisse d’un étudiant accusé à tort d’avoir triché ou de la remise en cause du contenu original d’un auteur. C’est pourquoi de nombreux développeurs d’outils (Turnitin, GPTZero, etc.) s’efforcent de minimiser les faux positifs, même s’ils ne parviennent pas à détecter toutes les utilisations de l’IA.

- Faux négatifs – Le revers de la médaille est également un problème : les détecteurs peuvent ne pas détecter le contenu généré par l’IA, en particulier si le texte a été modifié ou provient d’un modèle sur lequel le détecteur n’a pas été entraîné. Par exemple, Originality.ai a obtenu de bons résultats avec le texte GPT-4, mais a eu du mal à détecter le texte généré par Claude dans une étude. Comme les modèles d’IA se diversifient (avec de nouveaux systèmes comme LLaMa, Bard, etc.), un détecteur peut ne pas reconnaître leur style immédiatement. Les faux négatifs signifient qu’un détecteur peut donner un faux sentiment de sécurité – un étudiant peut faire passer un contenu écrit par l’IA par un paraphraseur et le détecteur indique alors « 0% AI » (nous avons observé exactement cela avec Hive et ZeroGPT, qui ont indiqué « 0% AI » pour certains passages paraphrasés qui étaient en fait de l’IA).

- Facile à tromper avec des astuces simples – Les détecteurs actuels peuvent souvent être déjoués par des techniques adversariales étonnamment simples. Des chercheurs de l’UPenn ont démontré que des méthodes telles que la paraphrase de textes, l’utilisation de synonymes, l’insertion de fautes de frappe ou d’espaces superflus, et même le remplacement de caractères par des homologues (homoglyphes) peuvent réduire considérablement le niveau de confiance des détecteurs. Par exemple, l’ajout de quelques fautes d’orthographe ou le remplacement d’un mot sur dix par un synonyme peut permettre à un texte d’IA d’échapper à de nombreux détecteurs (parce que ces méthodes augmentent la perplexité du texte, le faisant paraître plus « humain »).

- Biais et équité – Au-delà du biais de la langue maternelle, d’autres biais suscitent des inquiétudes. Certains craignent que les détecteurs ne signalent de manière disproportionnée les écrits de certains groupes démographiques ou dans certains dialectes comme relevant de l’IA. Par exemple, les écrits créatifs ou les poèmes qui ne respectent pas les règles conventionnelles pourraient dérouter les détecteurs. De même, les textes rédigés par de jeunes étudiants (dont la structure est plus simple) pourraient être injustement signalés par rapport à ceux d’un étudiant plus âgé. Un article a souligné le champ de mines éthique des détecteurs : de fausses accusations pourraient « accroître les inégalités en matière d’éducation » et marginaliser certains groupes. Bien que les preuves concrètes au-delà de l’étude sur les élèves non autochtones soient limitées, il s’agit d’un domaine à surveiller. La question des préjugés s’étend également au domaine du contenu – les détecteurs formés principalement sur Wikipédia et les actualités pourraient avoir des difficultés avec les codes, les listes ou d’autres formats de texte.

- Fiabilité et étalonnage – De nombreux détecteurs, en particulier ceux à code source ouvert, ne sont pas correctement calibrés par défaut. Le benchmark RAID de l’UPenn a révélé que certains détecteurs ouverts utilisaient des seuils qui conduisaient à des taux de faux positifs « dangereusement élevés » dès la sortie de la boîte. Cela signifie que si l’on prend simplement un modèle d’IA (comme l’ancien classificateur GPT-2 d’OpenAI) et qu’on l’utilise sans réglage minutieux des seuils, la moitié des objets détectés pourraient être considérés comme de l’IA. D’autre part, certaines entreprises calibrent leurs outils (par exemple, en fixant un seuil élevé de sorte qu’ils ne marquent que lorsqu’ils sont très sûrs, comme le seuil de confiance de 98 % de Turnitin). Cette différence de calibrage explique en partie pourquoi des tests différents obtiennent des résultats différents pour le « même » outil. Par exemple, GPTZero réglé sur une précision élevée par rapport à un rappel élevé se comportera différemment. Le problème est que de nombreux outils n’exposent pas ces paramètres aux utilisateurs et n’expliquent pas non plus leur seuil de fonctionnement. Les utilisateurs sont donc à la merci du réglage de l’outil, qui peut ne pas correspondre à leurs besoins.

- Évolution des modèles d’IA – Les générateurs de textes d’IA s’améliorent et évoluent rapidement. Un détecteur qui a bien fonctionné pour GPT-3 peut trébucher sur GPT-4, car l’écriture de GPT-4 est plus cohérente et moins prévisible. De même, les modèles open-source (comme Vicuna, etc.) peuvent être affinés pour avoir un caractère plus « aléatoire » ou imiter le style humain, échappant ainsi aux détecteurs. Au fur et à mesure de l’apparition de nouveaux modèles, les détecteurs doivent être mis à jour. Par exemple, le propre l’OpenAI classificateur de texte de a été retiré en 2023 parce qu’il n’était pas assez précis, en particulier lorsque de nouveaux modèles sont apparus et que les gens ont trouvé des moyens de le contourner. Son taux de détection dans l’évaluation d’OpenAI n’était que de 26 % et son taux de faux positifs de 9 %, ce qui a conduit OpenAI à reconnaître qu’il n’était pas fiable et à l’abandonner.

- Contexte et utilisation partielle de l’IA – Les détecteurs actuels analysent généralement un texte donné de manière isolée. Ils ne connaissent pas le contexte de sa création. Si un être humain utilise l’IA pour rédiger un plan, puis écrit le reste lui-même, les détecteurs peuvent voir l’écriture de l’être humain et ne rien signaler. De même, si un humain rédige un brouillon et utilise l’IA pour peaufiner quelques phrases, de nombreux détecteurs considéreront que ces phrases sont humaines, car le style général est humain. Nous arrivons à un stade où la collaboration entre l’humain et l’IA dans l’écriture est courante (par exemple, un humain écrit puis demande à ChatGPT de suggérer des améliorations). La détection de l’assistance partielle de l’IA est une zone grise. Une forte probabilité d’IA peut être techniquement correcte (certaines phrases sont modifiées par l’IA), mais le travail global est un mélange. Cela soulève la question suivante : à quel moment un document est-il considéré comme « généré par l’IA » ?

- Absence d’analyse comparative standard – Jusqu’à récemment, chaque entreprise vantait ses propres mesures, souvent basées sur des données qu’elle avait elle-même sélectionnées. Nous avons vu GPTZero citer des chiffres tels que « aucun faux positif au seuil optimal » et Winston AI revendiquer une précision de 99 %, etc. L’ensemble de données RAID de l’université de Pennsylvanie constitue une étape vers un point de référence standard. Il révèle comment les détecteurs se comportent dans de nombreuses conditions et montre clairement que les affirmations de « 99 % de précision » ignorent souvent les cas contradictoires ou supposent un seuil parfait.