Si vous utilisez régulièrement des LLM, vous avez sûrement remarqué une chose : à chaque nouvelle tâche, vous vous retrouvez souvent à réécrire le même prompt.

Les templates de prompts (ou “prompt templates”) sont l’antidote à ce chaos.

Dans ce guide, on découvre ensemble les différents types de modèles de prompts et comment les utiliser, que vous soyez développeur ou simple utilisateur d’IA.

Que sont exactement les Templates de Prompts ?

Vous savez probablement déjà ce qu’est un prompt : c’est l’instruction, la question ou le contexte que vous donnez à un modèle d’IA pour qu’il génère une réponse utile.

Le template de prompt va plus loin : c’est une structure de texte réutilisable, avec des champs (ou “placeholders”) à remplir, pour ne pas avoir à réécrire votre prompt à chaque fois :

- Il contient des instructions fixes (l’échafaudage qui ne change pas).

- Il contient aussi des variables ou des champs (comme

{{sujet}},{{audience}},{{ton}}) que vous remplacez à chaque utilisation. - Au moment de l’exécution, vous injectez les valeurs spécifiques et obtenez le prompt complet, prêt à être envoyé à l’IA.

Qui les utilise ?

Les développeurs s’appuient sur les modèles de prompts pour assurer la cohérence de leur code. Il existe de nombreux frameworks de code pour cela :

- LangChain, par exemple, fournit

PromptTemplateetChatPromptTemplatepour que les ingénieurs puissent définir les prompts une seule fois, passer les variables dans un dictionnaire (dict) et les appeler de manière fiable dans leurs applications et agents. (Il supporte même la syntaxe Jinja/Mustache.) - LlamaIndex offre des classes similaires (y compris un formatage plus riche de type Jinja) pour des prompts structurés et testables dans des projets Python/TypeScript.

Mais les utilisateurs d’IA “classiques” peuvent aussi facilement les utiliser. La Console Claude d’Anthropic vous permet de créer des modèles avec des {{variables}}, et génère même des modèles prêts pour la production à partir d’un simple objectif que vous décrivez.

Côté Google, Vertex AI expose les modèles de prompts et des conseils de conception directement dans son interface et ses parcours d’apprentissage, ce qui est utile lorsque vous voulez des workflows reproductibles pour votre équipe.

Comment Coder des Templates de Prompts

En pratique, les modèles de prompts sont souvent intégrés dans le code ou les outils de développement.

2.1 Syntaxe des Placeholders & Formats de Modèles

Lorsque vous codez un modèle de prompt, vous devez choisir une syntaxe pour les placeholders (les parties variables). Voici quelques styles courants :

- Accolades simples — ex.

{sujet},{audience} - Accolades doubles — ex.

{{sujet}},{{ton}} - Moteurs de template comme Jinja2 ou Liquid — permettant des boucles, des conditions, etc.

Par exemple, dans le Semantic Kernel de Microsoft, la syntaxe utilise {{$variableName}} pour les variables dans les modèles. Semantic Kernel supporte aussi l’intégration de logique via la syntaxe Handlebars ou Liquid pour des usages plus avancés.

Dans LangChain (un framework populaire pour les applications IA basées sur les prompts), les modèles de prompts supportent soit la syntaxe f-string (“{var}”) soit le style Jinja2 (“{{var}}”). La classe PromptTemplate de LangChain permet de définir une chaîne de caractères (string) de modèle et de lister les variables d’entrée, puis d’appeler .format(...) (ou .invoke(...)) pour substituer les valeurs.

Voici un exemple Python minimal avec LangChain :

from langchain_core.prompts import PromptTemplate

template = "Génère un résumé de l'article sur {topic} en {length} mots."

prompt = PromptTemplate.from_template(template)

filled = prompt.format(topic="les prompts IA", length=100)

Ou avec des variables d’entrée explicites :

prompt = PromptTemplate(

template="Écris un email à {name} à propos de {offer}",

input_variables=["name", "offer"]

)

filled = prompt.format(name="Alice", offer="50% de réduction")

Utiliser le style Jinja2 a des avantages (ex. boucles, filtres), mais aussi des risques (si les entrées proviennent de sources non fiables). La documentation de LangChain conseille de préférer le mode f-string sauf si vous contrôlez les entrées du modèle.

2.2 Ajouter de la Logique : Conditions, Valeurs par défaut et Branchements

Un modèle de prompt puissant a souvent besoin de logique conditionnelle — “si cette variable est présente, inclure cette phrase ; sinon, l’ignorer.” Pour cela, on utilise typiquement un moteur de template comme Jinja2 ou Liquid.

Exemple en style Jinja2 :

Vous êtes un expert en {domain}.

Décrivez les points clés de {{topic}}.

{% if audience %}

Rédigez-le pour une audience de {{audience}}.

{% endif %}

Si audience est vide ou n’est pas fournie, le bloc if sera ignoré.

Certains systèmes (comme Semantic Kernel) supportent les expressions intégrées, les appels de fonction ou les sections conditionnelles dans les modèles.

Les moteurs de template permettent aussi :

- Des filtres (ex.

{{ nom | upper }}) - Des boucles (ex. itérer sur les éléments d’une liste)

- Des macros (fragments réutilisables)

Ces outils vous permettent de garder des modèles modulaires et DRY (Don’t Repeat Yourself). Mais plus vous intégrez de logique, plus le débogage devient difficile.

2.3 Intégration : Du Modèle à l’Appel API

Une fois que vous avez un modèle codé, vous l’intégrez dans votre flux d’appel à l’IA :

- Charger / enregistrer votre modèle dans votre système (fichier, base de données, gestionnaire de prompts).

- Lier les valeurs des variables (collecter les entrées pour les placeholders).

- Générer / formater la chaîne de caractères finale du prompt (ou la structure de message de chat).

- Envoyer au LLM ou à l’API d’IA.

- Optionnellement, analyser ou valider la sortie.

Dans LangChain, un objet PromptTemplate peut être passé directement à une chaîne (chain) LLM ou à un modèle de chat. En interne, LangChain gère le formatage et l’appel.

Voici un pipeline simplifié :

prompt = PromptTemplate.from_template("Traduis {text} de {src} vers {dest}.")

filled = prompt.format(text="Bonjour le monde", src="Anglais", dest="Français")

response = llm.predict(filled)Dans des configurations plus avancées, vous pourriez :

- Charger les modèles depuis un fichier JSON ou YAML

- Les versionner (ex. stocker dans git ou un “prompt hub”)

- Utiliser un service de gestion pour récupérer les modèles par leur nom

- Valider les prompts générés (ex. vérifier qu’il ne manque aucun placeholder)

2.4 Bonnes Pratiques & Pièges Courants

Lorsque vous codez des modèles de prompts, suivez ces pratiques pour réduire les erreurs et les maux de tête liés à la maintenance.

Échappement & Nettoyage (Sanitize)

Si les entrées utilisateur peuvent inclure des caractères ressemblant à des accolades ({, }), échappez-les ou nettoyez-les pour qu’ils ne cassent pas le rendu de votre modèle. Par exemple, Jinja2 a des mécanismes d’échappement.

Gestion des versions (Versioning)

Les modèles évoluent avec le temps. Gardez un historique des versions pour pouvoir revenir en arrière. Dans LangChain, vous pourriez utiliser des outils externes (ex. hubs de prompts, fichiers versionnés) plutôt que de vous fier uniquement aux classes de modèles.

Valider le rendu

Avant d’envoyer le prompt rempli à l’IA, loguez-le ou inspectez-le. Identifiez les placeholders manquants, les trous inattendus ou les sections vides. Il est toujours plus sûr de prévisualiser.

Éviter l’injection ouverte

Ne permettez jamais à une entrée non fiable de définir la logique du modèle (ex. du code Jinja2 brut), ou vous risquez une injection de template, où un utilisateur malveillant sort du contexte du placeholder pour insérer des commandes arbitraires.

Garder une logique minimale

Bien qu’il soit tentant d’intégrer beaucoup de branchements et de boucles, une logique complexe peut rendre les modèles opaques. Si la logique devient lourde, refactorisez-la dans le code (prétraitez les entrées) et gardez des modèles plus simples.

Tester les cas limites (edge cases)

Testez votre modèle avec des variables manquantes, des valeurs longues ou des caractères inattendus. Voyez comment le prompt généré se comporte. (Ex. que se passe-t-il si audience="" ou sujet=None ?)

Les Différents Types de Templates de Prompts

Les modèles de prompts correspondent souvent à des tâches ou des domaines spécifiques. Voici les catégories courantes, avec quelques remarques et pointeurs :

| Domaine / Tâche | Ce que fait le modèle | Remarques & sources |

|---|---|---|

| Génération de contenu | Créer des articles de blog, des posts pour les réseaux sociaux, des descriptions de produits, des plans, des textes publicitaires | De nombreuses collections de prompts incluent des modèles de contenu. |

| Résumé / Extraction | Condenser un long texte, extraire les points clés ou les entités | Utile lorsque vous avez de longues entrées et souhaitez des sorties structurées. |

| Question-réponse / Q&R | Étant donné un contexte + une requête, répondre à la question (parfois avec des références) | Courant dans les assistants de base de connaissances ou les chatbots. |

| Comparaison / Avantages vs Inconvénients | Comparer des fonctionnalités, des options, des solutions côte à côte | Aide les lecteurs à prendre des décisions. |

| Analyse / Perspectives | Interpréter des données, trouver des tendances, suggérer des implications | Ex. “À partir de ces métriques, qu’est-ce qui ressort ?” |

| Génération / Explication de code | Écrire du code, déboguer du code, expliquer des extraits de code | Fréquemment utilisé avec des audiences de développeurs ou techniques. |

| Classification / Tagging | Attribuer des étiquettes, un sentiment, des catégories à un texte | Fonctionne bien dans les pipelines de modération, de feedback, ou d’avis. |

Au-delà du domaine, il existe des “patterns” ou “modèles de conception de prompt” qui peuvent guider comment vous structurez vos instructions.

En voici quelques-uns utiles :

- Pattern du “vérificateur cognitif”

Vous demandez à l’IA de poser d’abord des questions de clarification avant de produire une réponse finale. Cela force la collecte de contexte.

Exemple : “Avant de répondre, de quels détails supplémentaires avez-vous besoin pour être précis ? Ensuite, répondez complètement.” - Modèle à structure imposée (placeholders)

Vous donnez une structure qui utilise des placeholders, forçant l’IA à s’en tenir à votre format.

Exemple : “Écrivez un communiqué de presse avec les sections : Titre : [TITRE]; Introduction : [INTRO]; Détails clés : [DÉTAILS]; Prochaines étapes : [ÉTAPES]; Contact : [CONTACT].” - Pattern de “l’interaction inversée”

L’IA vous pose des questions pour clarifier avant de continuer.

Exemple : “Je vais vous poser des questions jusqu’à ce que j’aie suffisamment de détails ; ensuite, je générerai votre réponse.” - Chaîne de pensée (Chain-of-thought) / Étape par étape

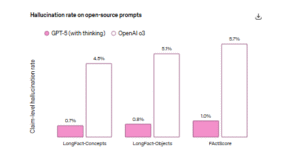

Vous demandez au modèle de raisonner par étapes, ou de réfléchir avant de répondre. C’est un pattern utile pour réduire les hallucinations ou les erreurs logiques. - Modèles Zero-shot vs Few-shot

Zero-shot signifie que vous donnez des instructions sans exemples. Few-shot signifie que vous incluez 1 à 3 exemples pour guider le style de l’IA. De nombreuses plateformes recommandent le few-shot pour des sorties plus précises. - Pattern des “garde-fous” (constraints)

Vous intégrez des règles ou des contraintes pour garder la sortie sûre, cohérente ou dans certaines limites (comme “pas plus de 120 mots,” “ne pas mentionner les prix,” “toujours inclure des puces”).

Exemples Concrets de Modèles de Prompts

Vous trouverez ci-dessous des exemples (modèle → rempli) pour différentes tâches.

Exemple 1 : Résumé / Ciblage d’audience

Modèle :

Vous êtes un expert en résumé.

Résumez le texte suivant pour une audience de **{{audience}}**, en **{{max_length}}** mots ou moins.

Texte :

“{{main_text}}”

Incluez les points clés et les implications.

Rempli (exemple) :

Vous êtes un expert en résumé.

Résumez le texte suivant pour une audience de **petits entrepreneurs**, en **150** mots ou moins.

Texte :

“[Long article sur les récents changements de politique de contenu IA …]”

Incluez les points clés et les implications.

Exemple 2 : Modèle de Comparaison

Modèle :

Comparez **{{feature1}}** vs **{{feature2}}** dans le contexte de **{{context}}**.

Produisez un tableau avec les colonnes : Fonctionnalité, Définition, Avantages, Inconvénients, Cas d'usage.

Concluez ensuite avec votre recommandation.

Rempli (exemple) :

Comparez **l'architecture sans serveur (serverless)** vs **l'architecture à base de conteneurs** dans le contexte de **déploiement d'applications web**.

Produisez un tableau avec les colonnes : Fonctionnalité, Définition, Avantages, Inconvénients, Cas d'usage.

Concluez ensuite avec votre recommandation.

Exemple 3 : Plan de Contenu / Brouillon d’article

Modèle :

Vous êtes un stratège de contenu.

Créez le plan d'un article de blog sur **{{topic}}**, destiné à **{{audience}}**.

Incluez 5–7 titres de section et 2–3 points clés pour chaque section.

Suggérez également un appel à l'action (call-to-action) à la fin.

Rempli (exemple) :

Vous êtes un stratège de contenu.

Créez le plan d'un article de blog sur **“Comment créer des modèles de prompts”**, destiné aux **marketeurs de contenu**.

Incluez 5–7 titres de section et 2–3 points clés pour chaque section.

Suggérez également un appel à l'action (call-to-action) à la fin.

Exemple 4 : Génération / Explication de Code

Modèle :

Vous êtes un développeur logiciel senior.

Générez du code en **{{language}}** pour **{{task}}**.

Expliquez chaque étape en commentaires.

Assurez-vous que le code gère les cas limites (edge cases) et inclut des vérifications d'erreurs.

Rempli (exemple) :

Vous êtes un développeur logiciel senior.

Générez du code en **Python** pour **fusionner deux listes triées**.

Expliquez chaque étape en commentaires.

Assurez-vous que le code gère les cas limites (edge cases) et inclut des vérifications d'erreurs.

Exemple 5 : Classification / Tagging

Modèle :

Vous êtes un classificateur de contenu.

Attribuez à chacun de ces **{{num_items}}** morceaux de texte un sentiment : Positif, Négatif, ou Neutre.

Textes :

{{#each texts}}

- “{{this}}”

{{/each}}

Retournez un objet JSON mappant chaque texte au sentiment.

Rempli (exemple) :

Vous êtes un classificateur de contenu.

Attribuez à chacun de ces **3** morceaux de texte un sentiment : Positif, Négatif, ou Neutre.

Textes :

- “J'adore la rapidité avec laquelle le support a répondu.”

- “L'interface est confuse et lente.”

- “Parfois j'aime les fonctionnalités, parfois non.”

Retournez un objet JSON mappant chaque texte au sentiment.Où trouver des Modèles de Prompts ?

Lorsque vous débutez, écrire tous les modèles à partir de zéro est fastidieux. Utilisez plutôt des galeries et des répertoires de prompts comme inspiration ou comme base pour les vôtres. En voici quelques-uns :

- Intellectualead.com— une bibliothèque d’exemples de prompts d’écriture dans des catégories de domaines telles que la rédaction de contenu, les médias sociaux et la recherche.

- Galerie de prompts Vertex AI — La galerie de Google d’exemples de prompts et d’aperçus de réponses.

- Modèles IA de ClickUp — inclut plus de 50 modèles de prompts pour le marketing, la rédaction, et la gestion de projet.

- Articles de Zapier sur les patterns de prompts — montre des structures réutilisables et des exemples.

Sauvegardez & Réutilisez Instantanément — IL Prompt Manager

Lorsque vous avez créé de bons modèles de prompts, le prochain obstacle est de les gérer : stocker, retrouver, mettre à jour et réutiliser sans friction. L’IL Prompt Manager est l’outil conçu exactement pour cela.

- Sauvegardez les prompts en un clic directement depuis l’interface ChatGPT. i

- Gérez et catégorisez vos prompts (dossiers ou tags) pour ne pas perdre la trace de vos modèles.

- Recherchez et retrouvez rapidement les prompts sauvegardés.

- Insérez ou réutilisez les prompts (ou modèles de prompts) dans ChatGPT avec une friction minimale.